随着互联网的普及和数字化转型的加速,大数据已成为当今信息时代的核心资产。从社交媒体的用户行为到电子商务的交易记录,从物联网设备的实时数据到企业运营的日志信息,互联网正以前所未有的速度和规模生成海量数据。这些数据不仅蕴含着巨大的商业价值,也对社会治理、科学研究等领域产生了深远影响。如何高效、准确地处理这些数据,并从中提取有价值的信息,成为当前面临的重要挑战。

数据处理是互联网大数据应用的关键环节,它涵盖了数据采集、存储、清洗、分析和可视化等多个步骤。数据采集需要从各种源头(如网站、移动应用、传感器等)实时或批量地收集原始数据。这通常涉及网络爬虫、API接口、日志收集系统等技术。采集到的数据往往是杂乱无章的,包含噪声、重复项或缺失值,因此数据清洗成为不可或缺的一步。通过数据清洗,可以去除无效信息,填补缺失值,并统一数据格式,为后续分析奠定基础。

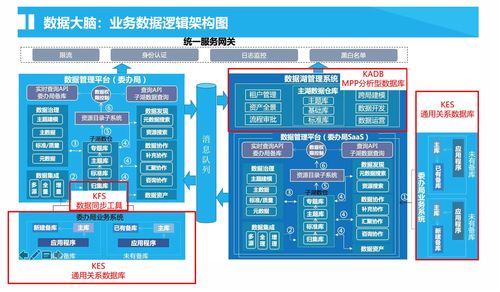

在数据存储方面,传统的关系型数据库已难以应对海量非结构化数据的存储需求。为此,分布式存储系统(如Hadoop HDFS、云存储服务)和NoSQL数据库(如MongoDB、Cassandra)应运而生。这些技术能够将数据分散存储在多个节点上,实现高可扩展性和容错性。数据湖(Data Lake)和数仓(Data Warehouse)等架构模式也为不同类型的数据提供了灵活的存储方案。

数据分析是大数据处理的核心,其目标是从数据中挖掘出模式、趋势和洞见。常见的数据分析技术包括描述性分析(历史数据)、预测性分析(利用机器学习模型预测未来)和规范性分析(提供决策建议)。例如,通过聚类算法可以识别用户群体,通过关联规则分析可以发现商品之间的购买关系。人工智能和深度学习的发展进一步提升了数据分析的深度和精度,使得图像识别、自然语言处理等复杂任务成为可能。

数据可视化则通过图表、仪表盘等形式将分析结果直观呈现,帮助决策者快速理解数据含义。工具如Tableau、Power BI等使得可视化变得简单易用。实时数据处理技术(如Apache Kafka、Spark Streaming)也日益重要,它允许企业对流式数据进行即时分析,从而支持实时监控、欺诈检测等应用场景。

尽管大数据处理技术不断进步,但仍面临诸多挑战。数据隐私和安全问题尤为突出,如何在利用数据的同时保护用户个人信息,成为企业和监管机构关注的焦点。数据质量、算法偏见、计算资源消耗等问题也需要持续优化。随着边缘计算、5G网络和量子计算等新技术的发展,大数据处理将更加高效和智能化。例如,边缘计算可以在数据产生源头进行初步处理,减少传输延迟;而量子计算有望解决某些复杂计算问题,加速数据分析进程。

互联网大数据处理是一个多学科交叉的领域,它融合了计算机科学、统计学、数学和领域专业知识。只有通过不断的技术创新和规范管理,我们才能充分发挥大数据的潜力,推动社会进步和经济发展。从智能城市到精准医疗,从个性化推荐到风险预测,大数据处理正在重塑我们的生活和工作方式,其未来充满无限可能。